模型介绍

模型地址:

在线体验:

11 月 20 日,由被称为「大模型应用开发创业者」傅盛创立的,全球领先的人工智能服务型解决方案提供商猎户星空公司,推出了一款基于零一万物开源的Yi-34B模型微调后的chat模型——OrionStar-Yi-34B-Chat。

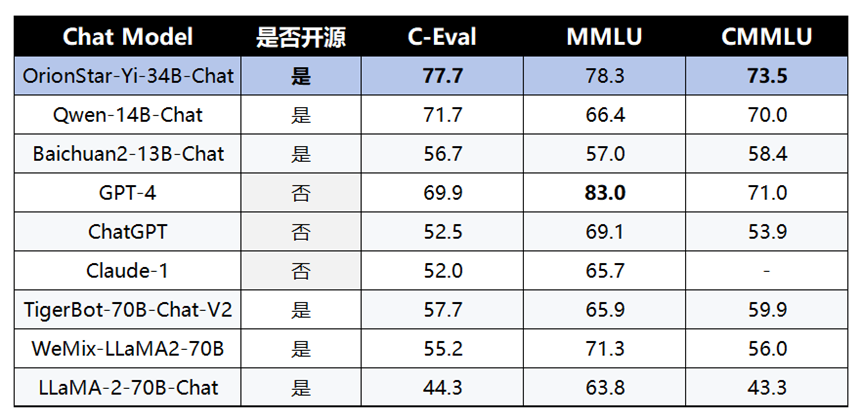

为了验证模型的各项能力,OrionStar-Yi-34B-Chat一经推出,在C-Eval和C-MMLU两个最具影响力的中文指标评估中,就以显著优势领先于Qwen-14B-Chat、Baichuan2-13B-Chat等国产大模型。

GPT-4固然能力强大,但闭源会要求企业访问公网以及难以定制化适配,使用场景受限。而开源能够使企业及超级个体轻松地借助专有数据进行微调和私有化部署,进而促进百行千业的良性发展生态。OrionStar-Yi-34B-Chat中英文大模型集高性能、完全开源、免费可商用等诸多优势于一身,可谓是ChatGPT最佳开源替代品之一。

OrionStar-Yi-34B-Chat多个评估基准表现最佳

作为国产优质大模型,OrionStar-Yi-34B-Chat更“懂”中文。为了验证模型的各项能力,OrionStar-Yi-34B-Chat在最具影响力的中文评估基准 C-Eval进行了综合评估,综合评分达到了77.7分,超过了同为国产大模型的 Qwen-14B-Chat、Baichuan2-13B-Chat,凸显中文世界的优异能力,可以更好的满足国内市场需求。

从更为全面的评估看,OrionStar-Yi-34B-Chat不仅在中文方面表现优异,在英文上表现同样亮眼。在全球大模型各项评测中最关键的 MMLU 英文权威评测榜单上,OrionStar-Yi-34B-Chat综合评分高达78.3,仅略逊色于 ChatGPT4 ,而比LLaMA-2-70B-Chat等某些参数规模更大的模型还要出色。

备注:

C-Eval 评测基准由上海交通大学、清华大学以及爱丁堡大学联合创建,是面向中文语言模型的综合考试评测集,覆盖了 52 个来自不同行业领域的学科。

MMLU 由加州大学伯克利分校等知名高校共同打造,集合了科学、工程、数学、人文、社会科学等领域的 57 个科目,主要目标是对模型的英文跨学科专业能力进行深入测试。其内容广泛,从初级水平一直涵盖到高级专业水平。

CMMLU是针对中国的语言和文化背景设计的评测集,用来评估LLM的知识蕴含和推理能力。该评测集跨多个学科,由67个主题组成。其中大多数任务的答案都是专门针对中国的文化背景设计,不适用于其它国家的语言。

更多细节维度的测评会持续更新在官方技术交流群。

为什么OrionStar-Yi-34B-Chat有如此亮眼的成绩呢?

1、Base模型基础好:作为大模型应用开发商,在Base大模型的选择上,猎户星空要对应用的质量负责,因此,对市面上广泛的开源模型做了测评,发现零一万物开源的Yi-34B模型表现确实优异。【聚言】是猎户星空自研的AI原生应用,我们用【聚言】进行实际的效果验证,Yi-34B模型在基于文本的理解能力、交互准确率及逻辑推理能力的效果最强。

2、15W+高质量中英文微调语料:我们知道微调数据是大模型训练的重要“燃料”,高质量、多样性的微调数据对大语言模型的对齐效果至关重要。我们在微调数据上花了大量时间和精力,使用了多种构建方案和人工精标及筛选,这些数据质量高、通用性强、覆盖面广、具备真实交互语料基础,对大型语言模型整个生命周期都有重要的影响,有助于大模型更好地适配实际的应用场景,实现人工智能赋能千行百业的愿景。

OrionStar-Yi-34B-Chat具体实践和经验分享

具体实践

我们知道高质量、多样性的微调数据是提高模型性能的关键因素,开源数据集质量普遍不高,多样性也较低,高质量数据需要人工精标!我们参考LLaMA-2以及intructGPT 定义了高质量、多样性的数据:

高质量:有帮助(helpful)、真实性(truthfulness)和无害性(harmlessness)详细见llama2论文。

多样性:任务多样、指令多样、覆盖领域多样, 再细点比如:指令长度及语种覆盖的多样。

数据具体构建思路如下

首先,我们基于数万条种子数据参考SELF-INSTRUCT、WizardLM、Orca、Backtranslation等基于大模型的方案去自动化构建一批初始数据,接着这些数据经过一个专门的数据质量模型进行评分和筛选,最终仅保留高质量数据。

紧接着参考 Platypus论文上方法做了数据去重、去污,保证数据严谨、有效。最后经过严格的人工精标,这些数据被进一步精炼,确保其无害性、真实性和实用性,最终形成了15W+高质量的微调语料。在数据筛选过程中,我们特别强调数据的安全性,加入了大量与安全相关的数据,以保证模型与人类价值观的一致性。关于数据的详细构建过程在猎户星空即将发布的自研大模型的技术报告里会详细说明,可以持续关注!

在具体微调的实践中,我们同时进行了两种微调方法:LORA和全参数量更新的微调,实际效果上基本也是全参数微调效果好于LORA。我们用DeepSpeed框架在4卡80G A100上使用ZERO3+Offload 策略,对这15W+数据进行了3个epoch的训练,分别在主观和客观测试集以及我们聚言业务的测试集上进行评测,给出了OrionStar-Yi-34B-Chat模型。这一过程不仅展示了猎户星空在技术上的创新和专业性,也体现了我们对质量和安全的不懈追求。