在大数据学习中,我们可以分为数据采集、数据传输、数据存储、数据处理、数据治理五大板块的学习。

在数据采集这个板块,可分为从哪里采集数据、以什么规则采集。互联网时代的带来给我们带来了多种数据格式类型的数据,包含结构化数据、半结构化数据、非结构化数据,数据采集的来源有系统日志、网络数据、传感器。系统日志的采集主要是通过浏览器、app、服务端进行埋点获取,比如用户访问点击数据、接口调用数据等,网络数据主要是通过爬虫等技术从网站进行获取。设备数据主要是通过传感器等从物理设备上进行采集。

在数据采集方确认后了之后,接下来的问题就是以什么规则分配数据存储、数据采集。数据量的暴增已经无法把PB级别的数据直接存储在单机系统里了,以分布式模式来存储数据是必须的,通过hash分片方式可以把数据分配到不同的机器中,再配合路由机制,就可以快速找到某一台机器上的某条记录。在数据的取舍上,可根据分布式的CAP/ACD/BASE原则来决定,在数据的更新上可采用主从式更新、各个机器节点同步更新、任一个节点更新的策略来处理数据。

在数据传输方面,一般有消息队列、数据同步等方式可以将采集的数据传输到存储通道。消息队列应该是现在互联网企业最常用的手段了,通过Kafka、RabbitMQ等消息队列,将服务之间解耦,生产者负责数据的生产,消费者按需订阅数据进行消费和业务处理。数据同步一般应用在数仓中,在各类数据源中将没有进行过任何加工的数据传递到数据仓库中。

在数据采集、传输之后,便是数据的存储了。存储方面一般有物理存储、分布式对象存储、大数据库存储等模式。物理存储定义是数据存储在磁盘上。存储类型方面支持文件存储、块存储、对象存储。分布式存储主要是提供多存储节点来实现海量数据的存储和方面,支持高可用、高性能、高伸缩性。大数据库存储主要是针对特定类型或离线分析使用,比如clickhouse、hbase、elasticsearch等大数据库直接统计分析使用,mongodb等文档数据库主要是存储半结构化数据。

在数据处理方面,主要使用流式计算、大规模批量计算等方式将数据进行加工处理,赋能业务。在实时处理方面,一般是使用flink、spark、storm等流式计算方式来对数据实时处理。大规模批量计算主要就是离线分析了,通过mapreduce、hive等离线计算方式来对数据进行加工处理,适合数据实时性要求不高的业务。

经过了数据采集、传输、存储、处理阶段后,数据产生了它的价值,可以更好的用于业务决策、运营分析。但是随着数据量的越来越大、业务的越来越复杂,对于数据的治理是势在必行。数据治理包括元数据管理、数据质量把控、数据安全三方面。元数据一般是指数据与数据之间的关联信息,通过生命周期管理、业务属性管理可以让管理员更好的做系统维护管理。在数据质量上主要通过一些流程上的质量管理控制体系进行把控,在数据安全方面主要从数据采集安全、数据传输安全、存储安全、应用安全等几方面去把控,企业在掌握了更多的用户信息之后更应该做好安全方面的管控。

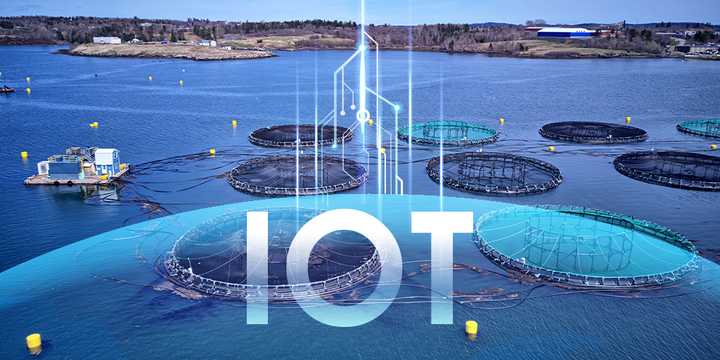

对海量数据的存储、计算、分析、治理除了上面介绍的专业内容之外,还需要掌握分布式技术、高并发处理、高可用处理、集群、实时计算,需要了解微服务架构、云计算、云原生、物联网、5G等概念。